2021年10月23-24、30-31日,第一届雷达学报博士论坛成功举办!

永利集团陈少武10月31日在雷达相关技术分论坛做了题为《深度神经网络压缩》的学术报告。

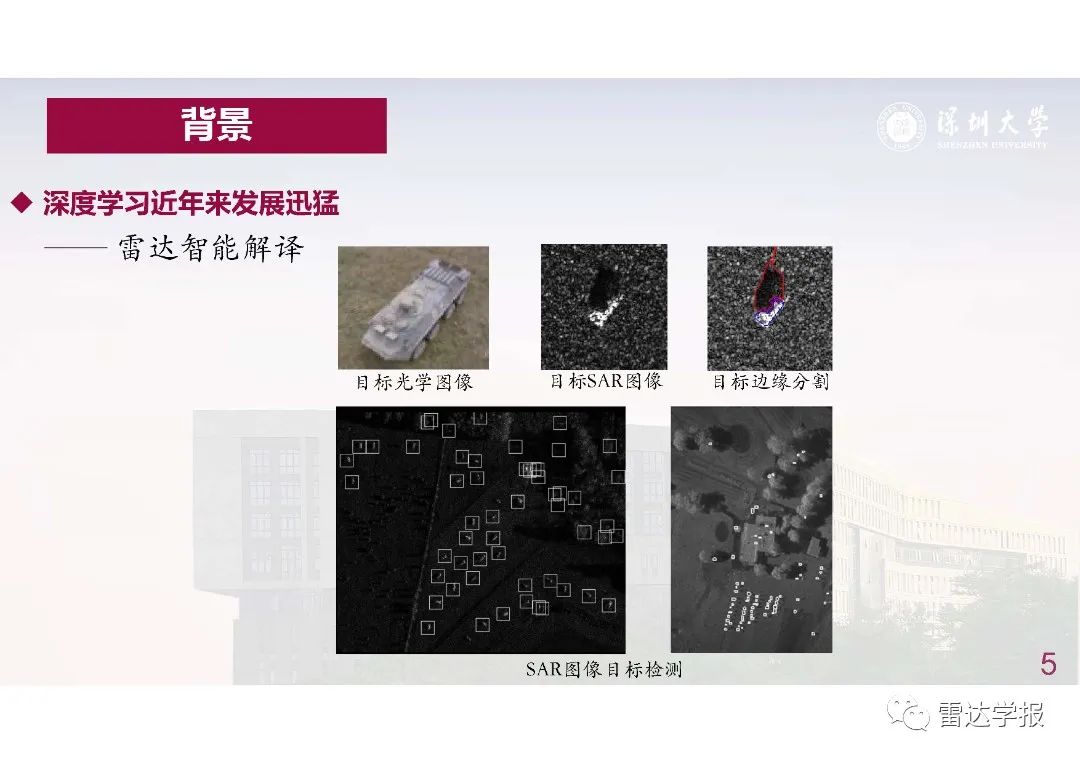

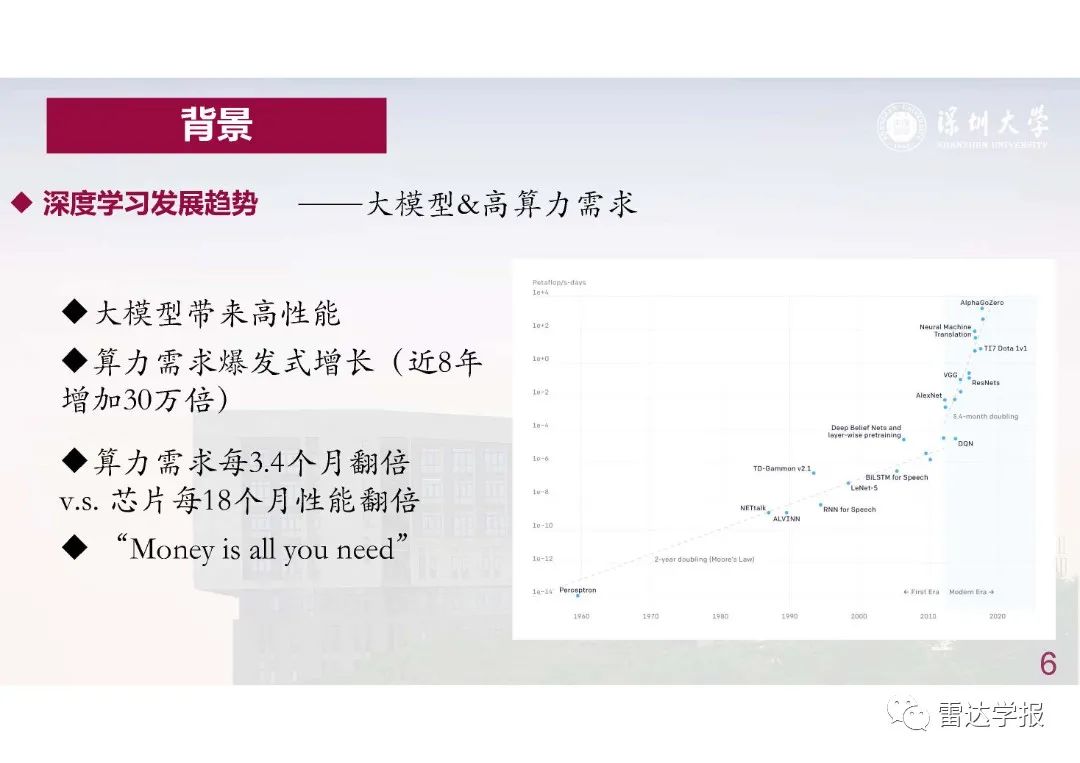

近年来,利用深度学习,雷达信号处理领域实现对目标的高精度检测和实时跟踪。层数越来越多的深度模型带来了更高的模型精度,但这也令参数规模愈加庞大的模型无法嵌入到雷达系统所处的小算力平台。

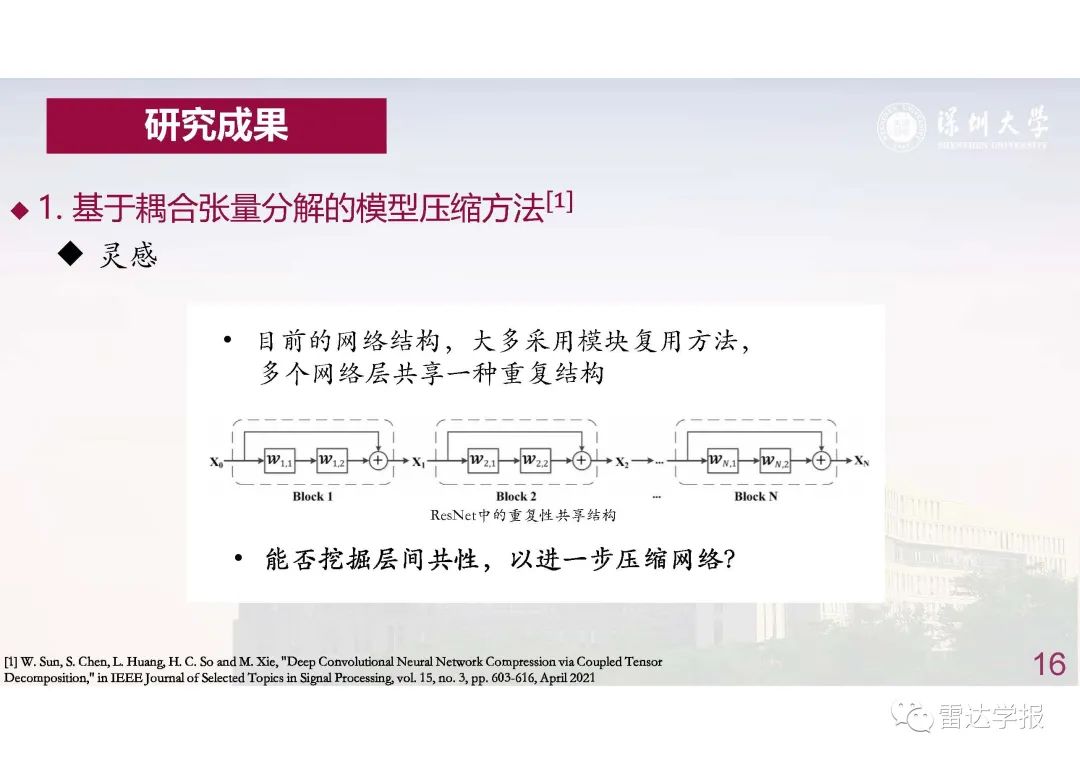

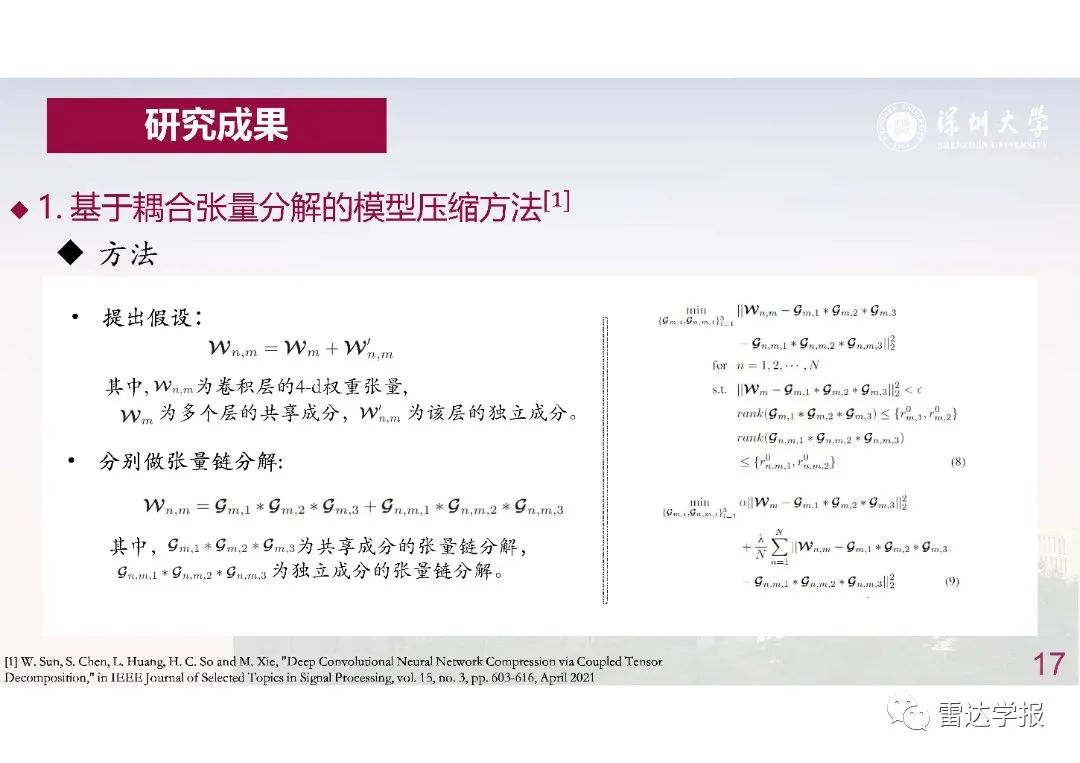

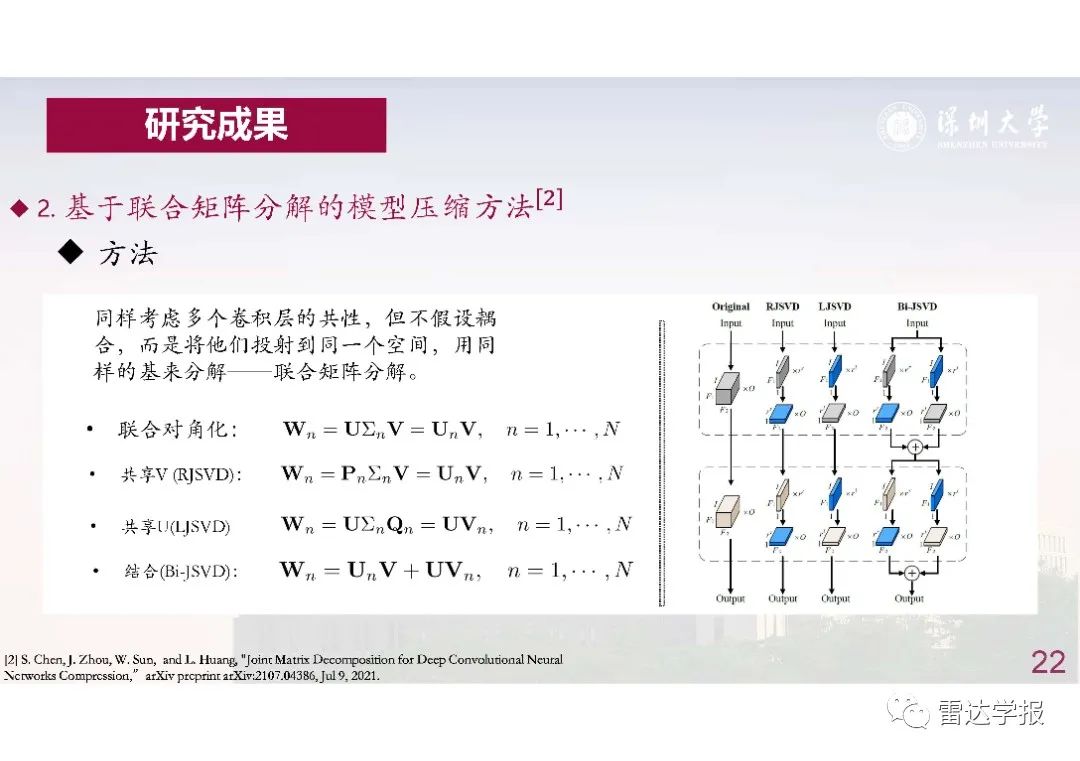

为了解决这个问题,模型压缩方法应运而生。然而,以往的模型压缩方法只考虑了每个权重张量的独立冗余性,压缩效率较低,且性能衰减较大。为了取得更大的压缩倍率同时尽可能的保持原始模型精度,我们提出利用神经网络层间的共性,以耦合张量分解的方法压缩神经网络,使得不同层共享部分权重,进一步地压缩网络并实现网络推断加速。

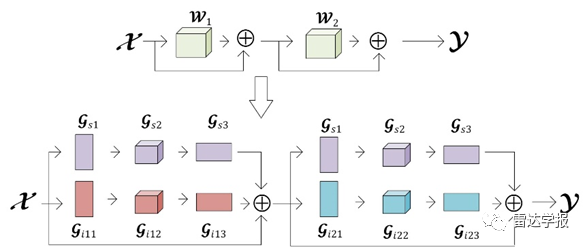

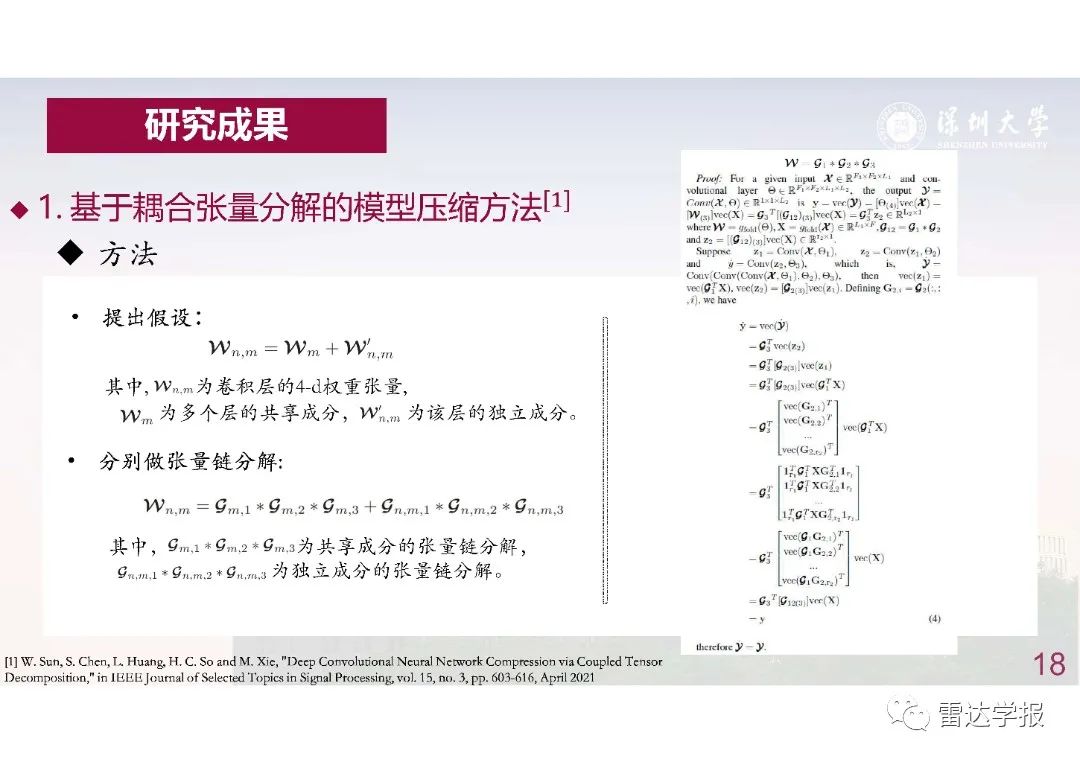

前沿深度模型中存在大量重复的卷积层。我们假设这些位置一致、结构重复的卷积层的权重张量如 ω1,ω2具备耦合共性,即拥有独立分量与共享分量:其中为共享分量: ω1=ωs+ωi,1,ω2=ωs+ωi,2,其中ωs为共享分量,ωi,1和ωi,2分别为ω1,ω2的独立分量。据此,分别对他们的独立与共享分量进行张量分解实现耦合张量压缩(NC_CTD):

ω1=ωs+ωi,1=Gs1*Gs2*Gs3+Gi11*Gi12*Gi13

ω2=ωs+ωi,2=Gs1*Gs2*Gs3+Gi21*Gi22*Gi23

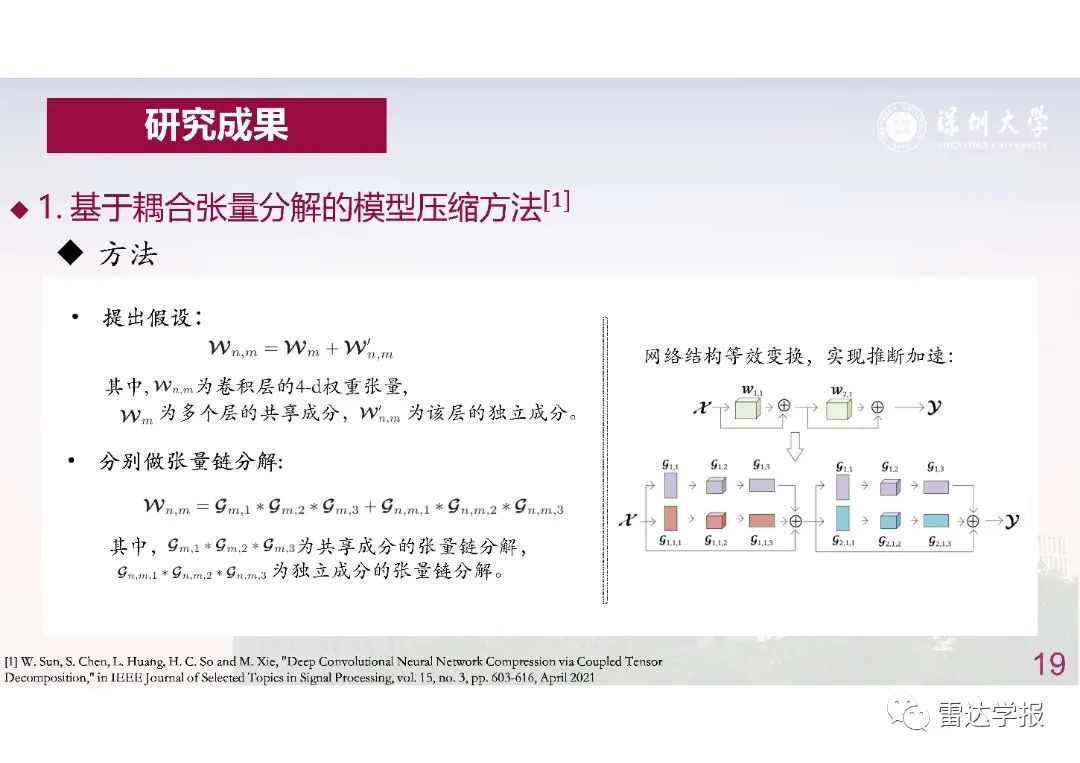

通过控制秩的保留数目,可以控制参数压缩的倍率。而利用该压缩算法,等效地将一层卷积层替换为三层复杂度更低的卷积层,实现推断加速,如图1所示。

图1:NC_CTD分解压缩。

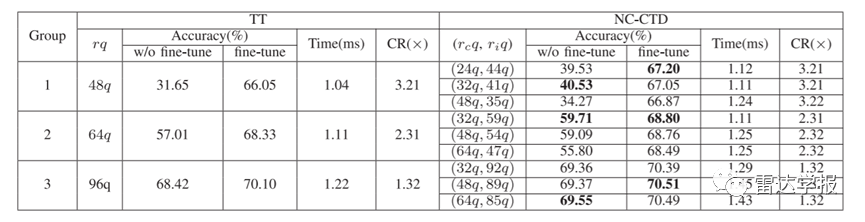

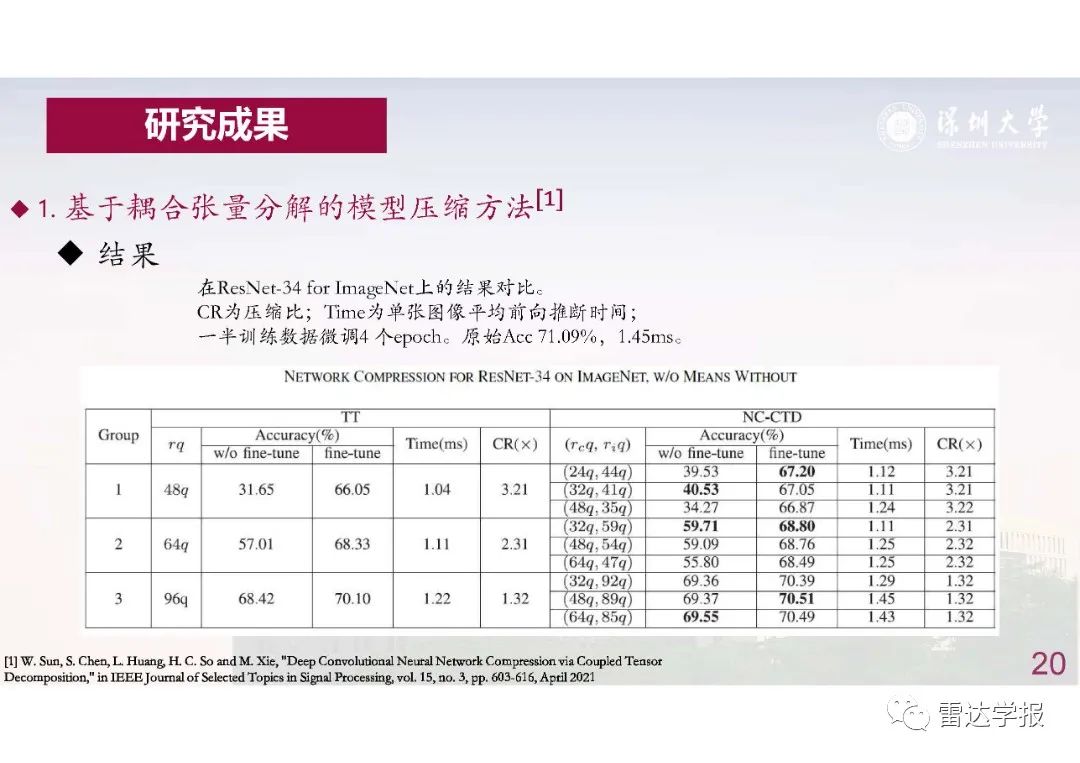

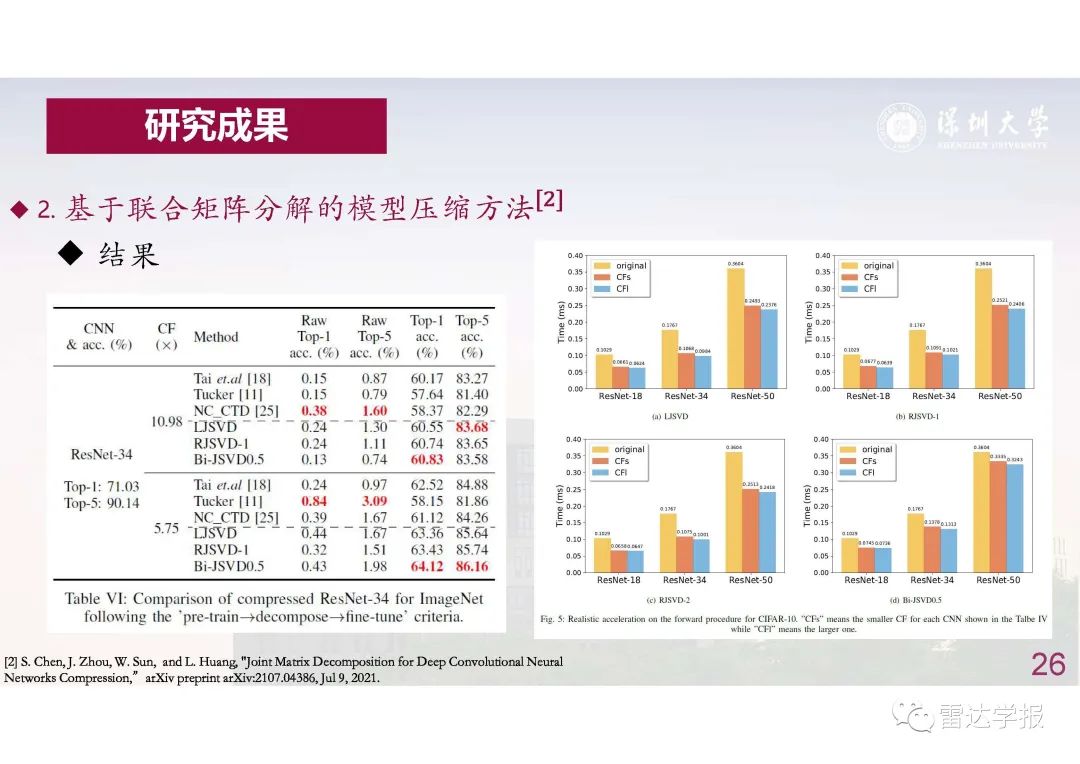

表1:在ImageNet数据集ResNet-34分类任务上的压缩结果。“CR”表示压缩倍率,“TT”为对比方法,“Accuracy”为对比指标。

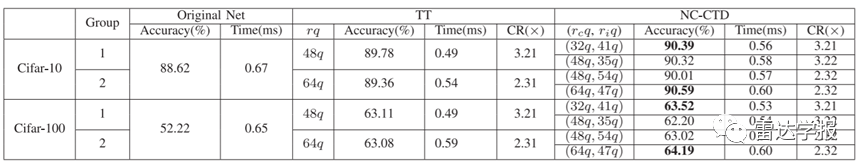

表2:迁移学习任务上的网络压缩性能对比。“Time”表示单张图片的前向推断耗时。

如表1和表2所示,通过利用层间共性,耦合张量分解方法(NC-CTD)在不同数据集和任务上均取得了好于同类算法的性能表现,准确率高出基线方法0.5到1个百分点。同时,对比原网络的前向推断时间,NC-CTD方法实现了推断加速。

本报告PPT共27张。

陈少武,2019年毕业于永利集团电子信息工程专业,目前在永利集团多维信号处理实验室黄磊教授的指导下读取博士学位。研究兴趣包括矩阵与张量分解算法,深度神经网络压缩加速及其应用。